4. Árboles de decisión

Agenda

- ¿Qué es un árbol de decisión?

- ¿Cómo se construye un árbol de decisión?

- ¿Cómo se evalúa un árbol de decisión?

- ¿Cómo se elige un árbol de decisión?

Árboles de decisión

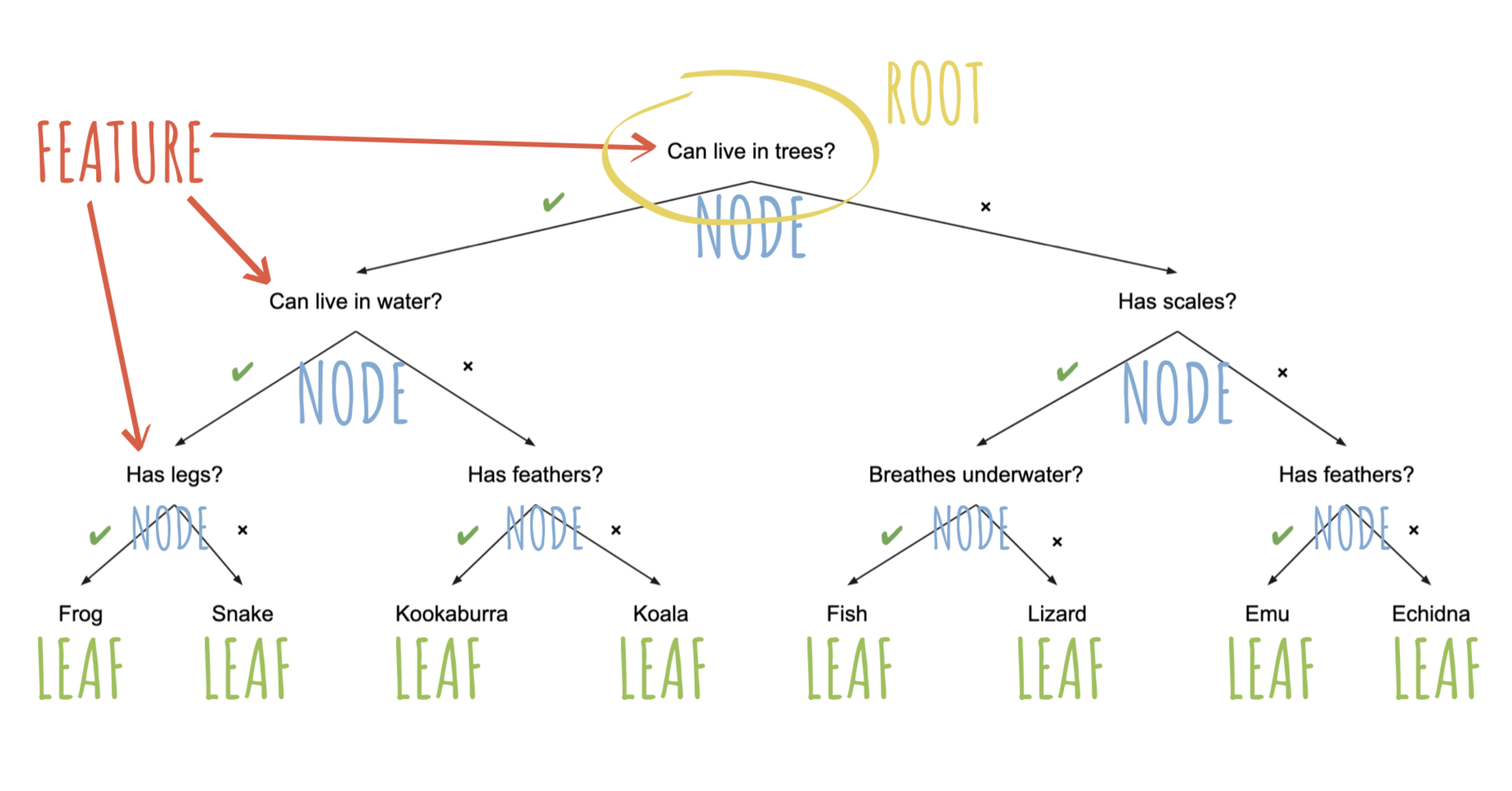

(mejorar esto) El objetivo es tomar una serie de decisiones, basadas en las respuestas a cada pregunta, para llegar a una conclusión o predicción final. Cada nodo del árbol representa una característica de los datos que se están analizando y cada rama representa una posible respuesta a esa característica.

Los árboles de decisión son útiles porque proporcionan una forma fácil de visualizar y entender cómo se toman las decisiones en un modelo

Arbusto

https://mlu-explain.github.io/decision-tree/

Árboles de clasificación y regresión (CART)

custom_metrics(resultados_prueba_tree,

truth = PYALC,

estimate = .pred_class

) |>

mutate(model = "tree")

tree_metrics <- custom_metrics(resultados_prueba_tree,

truth = PYALC,

estimate = .pred_class

) |>

mutate(model = "tree")

rbind(tree_metrics, lm_metrics) |>

pivot_wider(names_from = model, values_from = .estimate)CART con hiperparametros

Los hiperparámetros son valores específicos para los modelos que se pueden ajustar y que permiten controlar el proceso de entrenamiento de un modelo.

tree2_predicciones <- predict(tree2_results, entrenamiento)

resultados_prueba_tree2 <- cbind(tree2_predicciones, datos_entrenamiento) |>

tibble()

tree2_metrics <- custom_metrics(resultados_prueba_tree2,

truth = PYALC,

estimate = .pred_class

) |>

mutate(model = "tree2")

rbind(tree2_metrics, tree_metrics, lm_metrics) |>

pivot_wider(names_from = model, values_from = .estimate)¡Pero todo esto pasa en los datos de prueba!

¿Por qué es malo?

datos_prueba2_out <-

datos_prueba |>

select(PYALC)

lm_predicciones <- cbind(predict(lm_results, datos_prueba), datos_prueba2_out)|> mutate(model="lm")

tree_predicciones <- cbind(predict(tree_results, datos_prueba), datos_prueba2_out)|> mutate(model="tree")

tree2_predicciones <- cbind(predict(tree2_results, datos_prueba), datos_prueba2_out) |> mutate(model="tree2")

all_models <-

rbind(lm_predicciones, tree_predicciones, tree2_predicciones)

all_models¿Cómo vamos a elegir el mejor modelo si solo evaluamos el modelo en los datos de prueba?

Machine Learning